虚拟制作已经以某些形式在业内存在了好几年,而我们最近认识的所谓“LED虚拟影棚的虚拟制作”已然进化发展,提供了更多创意性与技术性的选择。这些工作流现在对于不同规模的预算也更为灵活和可及。但虚拟制作并不适用于每一个镜头或每一部电影。正如我们所采访的一位所说:虚拟制作并不是万能的解决方案。

让我们进一步来了解虚拟制作设备制造商和设备应用者们都说了什么吧……

吕克·德拉马尔 Luc Delamare | Impossible Object

这家虚拟制作工作室运用实时技术与LED虚拟影棚提供拍摄、视效、动画、虚拟美术部门(VAD)和可视化服务。

你现在主要从事虚拟制作的哪个方面,对不远的未来又有什么计划?

我们当前的服务涉及虚拟制作的几个领域,包括ICVFX(机内视效)和LED虚拟影棚拍摄,虚拟美术部门,可视化预览,以及直接从虚幻引擎完成最终成片CG动画。过去,我们成功掌握了混合虚拟制作和绿幕工作流,未来,我们希望在实时领域合并我们的视效管线。

你使用虚拟制作是为了省钱吗?还是为了更高效工作?或者都有?

我们发现,我们一直在问什么工具才是合适的创作工具。有时候是ICVFX,那让我们浓缩了后期日程,跳过冗长的视效工作流。有时候则是用于自动化工作的完全在引擎内完成的可视化,让我们用一套软件包就能运行整个CG管线。无论作品是什么,如果我们运用了我们手头能用的任何虚拟制作工具,那是因为它能让我们的团队拥有更好的创作效率,一般来说能给我们和客户省时间和省预算。

你提到使用LED虚拟影棚或绿幕。能展开说说吗?

在Impossible Objects公司,我们越来越倾向于使用LED虚拟影棚而不是以绿幕进行的混合虚拟制作工作流,虽然总是会遇到(需要使用绿幕的)时间或地点。有了ICVFX,业内发现,集齐关键主创、客户和艺术家们在一个实时环境里一起工作的这个优势,常常成为大家参与大众所理解的“虚拟制作”的一个很好的说辞。

你的实时拍摄有多少依赖于实时3D,又有多少依赖预渲染3D或视频内容?

我们有一个内部的虚拟美术部门,所以我们的大部分项目都是3D实时搭建的,让我们可以尽量贴近源素材来设计和打造创意。我们能够有效利用这些工具,并且不会在虚拟制作并非最佳解决方案时硬要使用,对此我们对自己感到骄傲。我们还熟悉掌握用于ICVFX显示的实拍原档拍摄,它对于汽车拍摄项目来说已经变得越来越常见了。

对你和你的公司来说,虚拟制作工作流中最困难的部分是什么?

当我们能够向客户和经纪公司展示我们可以通过运用ICVFX有效减少对繁重的后期工作的需求时,总是很难让他们明白这样会需要延长前期制作时间来进行平衡。虽然设计虚拟环境已经成为一种更有效的流程,在前期制作中能进行迭代和反馈仍然很重要。对于ICVFX,要对拍摄过程中要采集的图像进行很多处理。“靠后期修”就变成了“靠前期修”,虽然看似简单,但当你说的是一个大家已经很熟悉的流程,这其实是个困难的转变。

你的工作流中使用的是什么软件套装?

我们的虚拟制作和动画管线都植根于虚幻引擎,而我们的视效使用SideFX Houdini和Foundry Nuke。

凯利·希普曼 Kelly Shipman | Puget System

Puget公司专攻高性能、定制型电脑,他们还提供个人咨询与支持服务。

你们为虚拟制作工作流提供什么工具?

我们为各类虚拟制作工作流提供一系列工作站和架装安装服务器。无论是VAD的内容创作系统,驱动大型LED虚拟影棚的多服务器,还是其他相关服务,我们都有相应的系统可以让创作者实现自己的构想。

我们还跟Vu合作制作他们的Vu One LED套装。这些是一站式的产品,自带实现ICVFX所需的所有软硬件。

这些工作流属于高端制作还是所有人都可用/可负担得起?

我们的产品有各种不同的价位,并且可以定制来符合终端用户的目标和预算。我们的顾问会为你服务,确保你获得满足需要的最佳产品。

你们正在做哪些努力来让虚拟制作工作流与标准做法统一起来?

虽然我们并不创造新的做法或工作流,但我们会跟硬件商密切合作,为前沿的工作流提供和验证不常见的部件,比如符合SMPTE ST 2110标准的网卡,同步卡等等。

还有,正如前面提到的,我们跟虚拟制作专家Vu Studios合作,将其Vu One推向市场。这是一种即插即用的产品,可以让用户轻松开始LED墙拍摄。它提供了所有必须的软硬件,用户无需再联络十几个厂商并确保一切相互兼容。

为了实现更好的集成,什么标准还缺乏或不完善/没得到广泛支持?

最大的未得到完全支持的标准是SMPTE ST 2110。虽然那是广播行业普及的标准,但要加到许多ICVFX工作流并不容易。主要是因为虚拟制作的硬件难以获得,比如Nvidia的BlueField DPU和ConnectX SmartNIC,还有支持的LED处理器。DPU和NIC是许多行业的低用量产品,而随着基于GPU的AI服务器的崛起,对它们的需求会增加。

你们现在如何运用神经辐射场(Neural Radiance Fields,缩写NeRF)——或计划怎么用——那会给行业带来什么?

我们与我们运用NeRF的消费者密切合作,以明确他们特定的工作流,并进行测试来判断对他们来说最佳的硬件。目前,单一的普及的行业标准工作流尚未出现。我们的目标是在用户探索此工作流时支持我们的用户,并随着工作流越来越标准化而做好准备。

有没有什么我们没问到,但很重要的事情?

随着虚拟制作的发展和成熟,对处理不同宽高比的特定工作流的需求也在增长。ICVFX、VR、previz、动捕、绿幕、资产创建等等的软硬件需求都不同。虚拟制作涉及电影制作的方方面面,并且不仅限于LED虚拟影棚的应用。

对于在这个领域起步也有诸多误解。很多人以为,起步需要大量的专业硬件,但有很多方式可以让一个人以最小的投资学习这套工作流,同时实现令人惊艳的结果。

大卫·道林 David Dowling | Pixotope

Pixotope为内容方和制片人提供可持续的端到端虚拟制作平台。

你们为虚拟制作工作流提供什么工具?

我们的首要目标是精简虚拟制作工具和工作流,让创作者可以专注于创造引人入胜和沉浸式的视觉画面,无需担心技术挑战。我们在这个领域拥有一个独一无二的特长:在早期阶段,虚幻引擎缺乏关键的广播能力,比如抠像和填充功能,那是我们从头开发并集成到引擎中的。

这里一定要注意的是,我们不是个插件。我们反而是创造了一个虚拟制作生态系统,它掌控着虚幻引擎的力量,同时对我们的解决方案保持完全的控制。我们在虚幻引擎之上设计的用户体验确保创作者感觉它是用户友好、可靠且实用的。

Pixotope提供一个全面、实时的虚拟制作平台,它包含了所有增强现实、扩展现实和虚拟布景的关键组成部分。这包括全面的摄影机和演员跟踪能力。我们提供图形引擎,负责在实时虚拟制作中生成虚拟元素,将它们与实体元素无缝衔接。我们的摄影机跟踪技术可以无缝融合真正的摄影机运动和虚拟摄影机运动,确保真实世界和虚拟世界之间的完美对齐。

这些工作流属于高端制作还是所有人都可用/可负担得起?

我们的宗旨是让所有创作者用上虚拟制作——跨越成本以及技术复杂性的门槛。Pixotope可以与现有工作流及技术无缝集成,简化执行与应用,因为它是专为结合合作伙伴技术与外部数据源而设计的。我们的解决方案在开发时就怀着一个目标:以可靠、使用简单的解决方案,只需更少的人和支持即可操作,来减少运营成本。

我们还通过Pixotope教育项目这样一个面向全行业的举措进行普及,此举措解决的是当前的人才短缺问题,同时培训新一代虚拟制作故事讲述者。此举措为学生和教育者提供Pixotope软件和工具的使用权限,以增进他们的技能,让他们与全球Pixotope社群的行业专家建立联系。我们与多个机构合作来实行该项目,以更好地支持、培训和启发虚拟制作人才。

虽然Pixotope教育项目给予学生在教育机构内获取虚拟制作工具的权限,但我们承认,很多学生在那些工作室或实验室之外,没有机会去培养和锻炼他们的技能。

这就引入了Pixotope Pocket。与Pixotope教育项目一起发布的还有Pixotope Pocket移动APP,它能为有抱负的虚拟制作创意者提供他们最需要的东西:教室之外对增强现实与虚拟影棚工具和工作流的简单、无拘无束的使用权。学生们只需他们的手机和PC电脑就能运用虚拟制作工具和工作流,并可在灵感爆发的任何地方创造强有力的沉浸式内容,就算是在自己的宿舍也没问题。

你们正在做哪些努力来让工作流与标准做法统一起来?

有一种争论是,虚拟制作工作流跟标准拍摄工作流的差异太大了,无法统一。基于此,很重要的一点是承认(在某些情况下),需要新的工作流或元素来让虚拟制作能在媒体和娱乐行业中“发挥作用”。然而,这也提供了普及虚拟制作的机会。我们以布光设计为例。通过提供超凡的用户体验和无缝集成,虚拟制作工具成为了布光设计师工具组中的又一工具。同样的处理方式可以应用到相对于实体布景的虚拟环境中。通过专注于让虚拟制作工具易于理解和使用,我们增强了现有的工作流和做法,而不是改变或扰乱。

为了实现更好的集成,什么标准还缺乏或不完善/没得到广泛支持?

SMPTE RIS OSVP倡议和其他类似标准都在努力促成一种标准化的处理方式,在处理视频信号的同时,携带和代表让实体摄影机输出与虚拟世界对齐所需的数据。这种数据包含了如镜头数据(焦距、光圈、焦点)和摄影机位置的元素。对此的一种标准化的处理方式不仅要简化集成,还可能减少所需硬件,尤其是现场所需硬件。

你们现在如何运用NeRF——或计划怎么用——那会给行业带来什么?

NeRF基于2D图像来采集复杂表面细节的能力,使其尤其适用于映射我们想要与虚拟图形融合的真实环境。比如,特别适用于一个你想使用增强现实的影棚,或在LED墙或绿幕前把实体物品与虚拟物品相融合。或在运用了增强现实的户外环境中。

吉姆·赖德 Jim Rider | Pier59

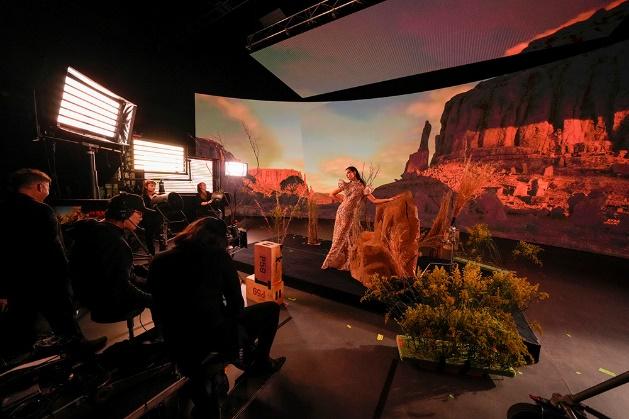

Pier59 Studios是一家位于纽约的虚拟制作影棚,所提供的LED影棚的主LED曲面屏为65英尺(约19.8米),所连接的天屏为40英尺(约12.2米)。

你如何运用虚拟制作?举一些你们虚拟制作作品的例子?

自今年2月我们推出了我们的大型LED虚拟影棚,Pier59 Studios已经为时尚与奢侈品牌进行了各种拍摄,包括Neiman Marcus、DKNY和Tom Ford。HBO的《继承之战》(Succession)和其他几个创新性的项目都在我们的虚拟制作影棚拍摄。这是一种极其灵活且功能很强的拍摄工具,可以对拍摄地点、天气、季节、时段进行创意控制——同时还能以一种有意识的环保的方式降低整体制作成本。

Pier59 Studios的LED虚拟影棚还成为了直播活动的内容画布。融合LED墙的主旨演讲、产品发布、研讨会等等活动提升了档次,让宾客拥有完全沉浸的体验。

你觉得人们使用虚拟制作是为了省钱?还是为了更高效工作?或者都有?

虚拟制作对于一系列项目和创意风格来说是一种十分有效的解决方案。比如,若一个项目涉及多个取景地和/或多个布景,虚拟制作的好处显而易见:减少出行,实体布景规模变小,变化更快,可以让每天完成更多摄影机设置(拍摄)。

若一个项目所设置的取景地是在现实中或资金上难以去到的一个地方,无论是火星还是纽约证券交易大厅,该环境的3D版本都可以导入LED墙。总的来说,能在根据某项目需求量身定制的布景上更快地工作,就是虚拟制作在财务和工作流上的优势。

你们提供LED虚拟影棚,不提供绿幕?

我们的C棚是一个65英尺×18英尺(约19.8米×5.5米)的LED虚拟影棚,它有一个相连的天屏以及四面活动墙板。将内容传给我们的主墙并直接对墙拍摄可以得到摄影机内直拍镜头,只需非常少或无需后期制作。我们常把这叫做“采集最终画面”。

使用LED墙作为绿幕当然是可能的,但绿幕有很多弊端(绿光溢散等),并且需要大量后期处理。绿幕拍摄会限制虚拟制作的关键优势之一:获得摄影机内直拍镜头。然而,因为我们的虚拟影棚有非常强健的色彩空间,若客户想要使用LED墙作为绿幕,它能比传统绿幕实现更简单和精确的抠像。

要让工作流更高效、性价比更高,还缺乏什么?

虚拟制作需要深入的技术与创意规划。比如,漏算将虚拟布景与实体布景融合起来所花的时间会阻碍拍摄进程。为确保该技术与工作流得到最佳应用,Pier59 Studios的虚拟制作团队会作为客户摄制组的延伸,提供虚拟制作技巧和操作的专业知识与咨询顾问服务。

对你和你的公司来说,虚拟制作工作流中最困难的部分是什么?

虚拟制作领域仍然在发生大量技术革新。但在过去几年中,运用虚拟制作的关键流程已经成形。像素密度紧凑的LED面板、精确的摄影机跟踪系统和强大的游戏引擎已经成熟到功能性与可靠性都相当高的程度。

现在最大的挑战在于教育与普及。许多客户并不熟悉这个流程,其实虚拟制作有很多传统拍摄工作流的元素,但它发挥作用的地方是在一条不同的、更前置的时间线上,这会给新用户带来始料未及的技术挑战。因此,Pier59非常积极地在教育我们的潜在客户,并提供必不可少的咨询服务,让摄制组可以更安心、更自信地使用我们的技术。

Pier59还通过提供测试拍摄努力为潜在客户介绍虚拟制作。我们发现,一旦创意经纪公司踏入我们的LED虚拟影棚,他们都会公开地表示很期待能在未来的项目中拥抱这种技术。

有没有什么我们没问到,但很重要的事情?

我们的客户主要会问的问题之一是:“我们从哪里获取内容?”我们可以创建自定义3D环境来匹配某个项目,但那确实需要前置时间来完成环境制作(这个制作工作以往是在后期完成的)。

会对虚拟制作产生重大影响的技术进步之一就是生成式AI可以辅助创建环境。这现在刚刚开始发生,但在几年内,我们就能用比现在快得多的很短的时间生成自定义环境。

杰夫·埃德森 Jeff Edson & 马泽·阿德霍尔德 Mazze Aderhold | Assimilate

Assimilate以Live FX和Live FX Studio软件为投影映射、基于图像的照明和实时合成提供精简的虚拟制作解决方案。

你们为虚拟制作工作流提供什么工具?

杰夫·埃德森:Assimilate为虚拟制作工作流开发了Live FX和Live FX Studio软件。Live FX主要针对绿幕摄影棚,这款软件作为一个实时键控和合成器。它还具有丰富的工具组,可实现基于图像的照明(image-based lighting,缩写IBL),软件刚刚更新至9.7版。

Live FX Studio主要针对基于LED墙的虚拟制作场景,它的主要功能是进行2D、2.5D、3D和180/360内容向任何大小的LED影棚的投影映射,包括虚拟场景扩展。此外,它还可以处理IBL(基于图像的照明)任务,甚至可以在LED虚拟影棚播放内容的同时从照明控制台进行控制。

这些工作流属于高端制作还是所有人都可用/可负担得起?

马泽·阿德霍尔德:这是两者的良好结合。我们专门为独立工作室开发了更亲民的Live FX,它主要用于绿幕拍摄。LED虚拟影棚天然需要更高的预算,因此Live FX自带更高级的功能来解决这些拍摄的媒体服务器要求。话虽如此,Live FX Studio还是性价比非常高的——不仅体现在软件成本上,还体现在硬件需求上。

其他解决方案可能需要多节点渲染集群,要各种高端硬件,而Live FX Studio从单一工作站就能驱动哪怕最大型的LED虚拟影棚。这就把持住了硬件所需的成本,并且还能大大降低耗能。作为一款相对轻便的软件应用,它可以在任何Windows或macOS工作站安装,我们提供月订阅套餐,年许可证和永久许可证选项。所有这些都让Live Fx非常容易获取,并且适用于众多制片厂。

你们正在做哪些努力来让虚拟制作工作流与标准做法统一起来?

埃德森: 一个比较有帮助的事情是我们在影视工作流中的经验。Assimilate在过去二十年间为调色、完成片制作和转码一直在开发Scratch。

通过其开发,我们了解了现场专业人士的技术与创意语言——我们的UI运用的就是这样的语言。

Live FX并不是一种编程环境,而是一个创意工具,可以快速而简单地实现复杂的虚拟制作场景。我们直观的UI帮助新用户短时间内学习Live FX,并很快能获得很棒的结果。

此外,因为我们拥有后期制作背景,Live FX还可以在现场采集元数据——囊括从实时SDI元数据到摄影机跟踪信息到用户输入元数据,比如场号、条数、注释,并为管线后续的后期制作(视效)准备好一切——这是其他虚拟制作解决方案常常只会在事后才想到的一个重要的工作流部分。

为了实现更好的集成,什么标准还缺乏或不完善/没得到广泛支持?

阿德霍尔德:标准很好——所以我们才有那么多标准。这是一位很有智慧的人说的。总的来说,真的要看我们行业最接受的标准是什么。通用场景描述(Universal Scene Descriptor,缩写USD)这种3D环境开源格式近来受到了一些关注,而ST2110承诺会大大简化现场图像管线,尤其是对于LED虚拟影棚。摄影机跟踪解决方案越来越接纳通用FreeD协议。

如今欠缺的是一种标准化的格式,它能让元数据——尤其是摄影机跟踪元数据——从片场传递到后期制作。

你们现在如何运用NeRF——或计划怎么用——那会给行业带来什么?

NeRF是一种非常棒的采集现实世界环境的方式。对于Live FX,它主要取决于NeRF是如何交付的。我们很喜欢以Notch Blocks和USD作为3D环境的载体——有那些,我们已经做好准备拥抱任何形式的NeRF。

有没有什么我们没问到,但很重要的事情?

我们作为软件开发者,最大的困难是兼容不同工作流。

因为虚拟制作仍然是一个非常前沿的领域,各种不同的工作流和工作流要求数不胜数。以一个UI统一处理所有并且简化所有,真的是一个挑战。

话虽如此,不断壮大的Live FX社群提供了非常棒的反馈和见解,我们很开心能兼容他们的项目需求。这非常有助于依据虚拟制作市场来打造Live FX,并让这款软件符合当前的创意要求和技术挑战。

安德烈·丹泽勒 Andre Dantzler | SociallyU

SociallyU通过录制视频与直播流,以照片级真实的抠像,高级虚拟制作和实时剪辑创建内容,帮助客户传达信息。

你现在主要从事虚拟制作的哪个方面,不远的未来又有什么计划?

当前,我们所拍摄的一切都在我们的三墙绿幕虚拟影棚完成,结合使用了虚幻引擎的虚拟背景,和实地多机拍摄的自定义实拍原档。我们的工作流涉及利用8台Blackmagic Ultimatte 12 4K摄影机素材的键控和8台Blackmagic Studio Camera 6K Pro摄影机来做实时合成。6台摄影机利用两个Vive Mars系统进行跟踪,剩下两台以Axibo PT4滑轨跟踪。一切都在ATEM Constellation 8K上实时剪辑。

未来,我们对3D高斯泼溅(3D Gaussian splatting)等新技术很感兴趣。这是一种新兴技术,我们觉得它会革新虚拟实拍原档拍摄。它能让我们把环境扫描并放到虚幻引擎中,然后用虚幻引擎做增强。它会给我们很多灵活性,惊人的渲染速度,和非常照片级真实的风格。

你使用虚拟制作是为了省钱吗?还是为了更高效工作?或者都有?

我们的第一动力是效率。有了虚拟制作,我们可以以数字方式创建环境,而不用为每个项目搭建实体布景。鉴于我们每月的项目拍摄数量,搭实景是没有可持续性的。效率让我们可以参与更多项目并不断成长。虚拟制作还能解锁创意可能性,比如可以轻松地在逼真的虚拟世界中替换演员。

在效率促进应用普及的同时,虚拟制作还能降低传统拍摄管线的成本,比如布景搭建和实地拍摄。

你的拍摄有多少依赖于实时3D,又有多少依赖预渲染内容?

目前40%利用虚幻引擎的实时3D。另外60%使用自定义的实景实拍原档。我们投资购买了一套很可靠的实时基础设施,每台摄影机都有专门的虚幻引擎电脑。

我们很喜欢真实的实拍原档的逼真度,但我们也很喜欢虚幻引擎惊人的多功能性。再次说明,我们希望如3D高斯泼溅这样的新技术能帮助我们将两个世界最好的效果融合起来。

要让工作流更高效,还缺乏什么?

- 照片级真实并为实时虚拟制作优化过的虚幻引擎布景。

- 更多自动化工具,比如AI辅助的布景生成。

- 更快的GPU。

- 找到具备虚拟制作技术与创意技巧的人才。

- 提升所涉及的各软件工具间的互操作性。

你使用的是什么软件套装?

我们的核心套装是虚幻引擎,主要用于实时渲染;

达芬奇用来为实拍原档调色和做合成;Photoshop用来给实拍原档自定义,包括AI生成的填充;OBS用于片场实拍原档可调节的回放,包括可调节背景的模糊量。

还有其他我没问到但很重要的东西吗?

一个关键的助力是我们以ChromaLight漆粉刷的绿幕影棚。ChromaLight漆拥有上乘的色彩均匀度,并能很好地抑制溢光。结合我们的Blackmagic Ultimatte 12 4K键控,它可以实现非常干净的合成。ChromaLight让我们的虚拟制作质量提升一个等级。

哈迪·坦克斯利 Hardie Tankersley | Silverdraft

Silverdraft公司制造超算体系架构来解决高端渲染、VR、视效、虚拟制作等等的计算需求。

你们为虚拟制作工作流提供什么工具?

高性能计算以驱动更快更好的渲染。从存储到网络到计算到管理的完全集成的计算堆栈来辅助功能更强的虚拟制作摄影棚和效果。Demon系列桌面与机架式工作站和渲染服务器为实现高性能计算,以驱动更快更好的渲染。Demon的Lair系统是一个涵盖从存储到网络到计算到管理的完全集成、预搭建且已经过测试的计算堆栈,能辅助功能更强的虚拟制作摄影棚和效果。

这些工作流属于高端制作还是所有人都可用/可负担得起?

我们可以调整系统大小,适配从小型、独立项目到复杂长片和活动的拍摄。一切都基于相同的管线,只是高端制作的系统规模更大,灵活性更高。

你们正在做哪些努力来让虚拟制作工作流与标准做法统一起来?

我们与我们的消费者在每次安装中深度合作,以及与Nvidia等我们的技术合作伙伴深度合作,来确保我们利用了常用的标准做法。我们是行业社群中不可或缺的一部分,全社群正在共同努力,为虚拟制作工作流形成标准、一致性、可预见性。

为了实现更好的集成,什么标准还缺乏或不完善/没得到广泛支持?

我们高度关注SMPTE ST 2110,并正在学习如何搭建和优化完全数字化的管线,同时供应商支持持续出现。我们相信,未来一定是所有数据流都会利用基于IP的网络。

你们现在如何运用NeRF——或计划怎么用——那会给行业带来什么?

NeRF是又一种生成3D资产的技术,工具箱里的又一种工具。我们一直在以很多不同方式生成体积资产。NeRF只是给了我们一种方法,在你只有视频的时候,也能生成资产。但如果你有资源,以传统的体积空间捕捉技术用激光雷达和摄影测量会更好。

有没有什么我们没问到,但很重要的事情?

虚拟制作是一个无尽的话题。光是谈论网络架构、存储、云工作流,当然还有高性能渲染,就能说上好几天。要涵盖所有内容是不可能的。但对我们来说,最重要的是表现性能。若你的计算够快,每个人的工作都轻松很多。高性能计算可以为工作流的每个部分带来效率,因为你就不用花那么多的优化和测试时间了。

米歇尔·苏伊萨 Michel Suissa | B&H – The Studio

B&H公司的The Studio一直在为大型电影制片厂、电视网、制作公司、后期公司、视效工作室等等提供视频解决方案。

你们为虚拟制作工作流提供什么工具?

很多。LED接块、传统布光和基于图像的照明解决方案、摄影机跟踪系统、媒体服务器、渲染引擎、高端工作站、摄影机与镜头、信号管理与分发、监看、网络、结构性硬件和电力配电。

这些工作流针对高端制作还是所有人都可用/可负担得起?或者都有?

我们面向市场的两端,提供性能与价位合适的解决方案。

可以做什么来让虚拟制作工作流与标准做法统一起来?

SMPTE RIS及其OSVP特别小组是一个非常棒的倡议,他们的目标是将工作流与最佳做法标准化。

为了实现更好的集成,什么标准还缺乏或不完善/没得到广泛支持?

通过虚拟制作管线实现的色彩完整性。此外还有互操作性、技术项目管理和元数据完整性。

你如何看待行业应用NeRF?人们需要知道什么?

使用NeRF仍是个新鲜事物,但它会和实时游戏引擎非常好地集成到一起。这是将通过基础现实摄影创建三维环境大众化的开端。

扩展阅读:2022虚拟制作行业大佬圆桌讨论

出处:Randi Altman | postPerspective

翻译:LorianneW | 盖雅翻译小组

-300x152.x33687.jpg)