每年,拍摄中录制的数据类型数量都在持续增加。因为其中每一个都描述了某一特定时刻,于是它们也需要可行的时间标签。这可不是ST-12的设计初衷。

如今,一段录制下来的特定时间段关联着多到难以置信的数据量。数据生成和时间标签的交汇要求使用能够明确自身视角的时间标签。这个标签同时也是媒体文件的标识。知道一个片段是何时生成的还不足以知道它的内容和性质。

没错,目前我们可以使用时间码进行同步。我们可以用它以时间重组不同的视角。但问题是,时间码实际上只支持视频帧。

相比之下,音频时长是从采样率和录音开始时采集的时间码值中得出的。它没有固有的时间码标准。其他以数据为中心的采集类型也是如此,比如动作捕捉、表演捕捉、遥测等等,这些都是虚拟制作所必需的。这些类型可按每帧采样,但也可在更高的分辨率下采样。此外,此类数据是文件优先的。它们会从计算机系统接收到一个时间戳,该时间戳是计算机在创建它们时创建的,这个时间戳与计算机(创建它们时处于)一天中的什么时刻有关。

由于时间码是任意的,并且可能不会使用一天中的某一时刻作参考,因此我们没办法有效地将这些同步化。

代际问题

就采集到的媒体片段而言,其生命周期自然不止于采集阶段。

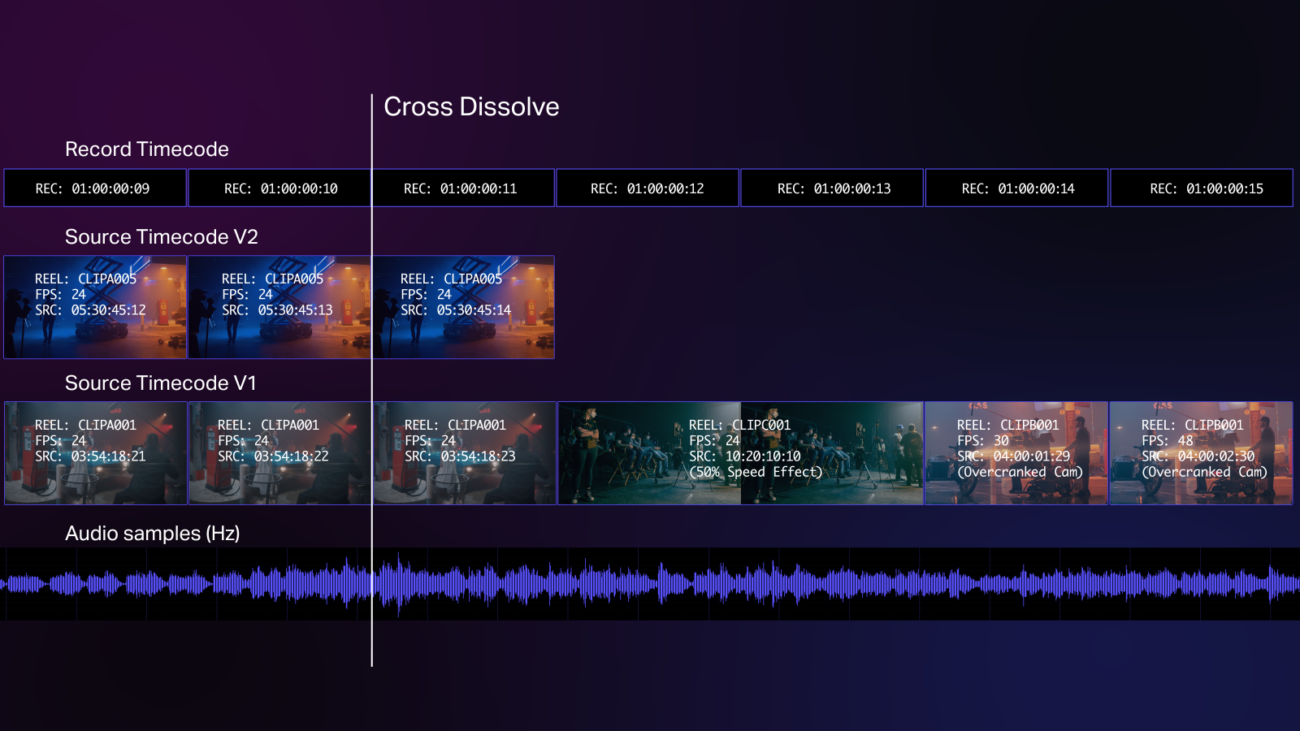

我们希望以时间识别媒体文件的主因是,这样我们就可以将其与其它视角的媒体文件组合起来,创建我们的项目了。我们添加带时间码的媒体文件的时间线和序列都有自己的时间码,因为剪辑中的每一帧都该有个与剪辑相关的时间标签。

这意味着,一旦带时间码的媒体文件添加到时间线,媒体文件的帧现在就有了两种不同的关联时间码值:源时间码(嵌入在源媒体中的时间标签)和录制时间码(由时间线分配的时间标签)。这两个术语都来自线性磁带剪辑——源时间码是“源”磁带的时间码,而录制时间码是最终成品(或“录制”)磁带的时间码。

在你检查典型项目的片段时长时,时间码的局限性就变得很明显了。

当然,随着更多同时发生的媒体文件(如同步音频、摄影机角度、立体视频、合成元素等)被添加到时间线中,这种情况会变得更复杂。而当剪辑师利用速度效果操纵时间时,情况会变得更加混乱。一旦用了这些效果,源时间标签就变得无关紧要了,因为帧的内容与其时间码值之间的链接被破坏了。

虽然时间线的时间码可以从任何值开始,但它通常从整数小时开始——一般都是00:00:00:00或01:00:00:00:00。虽然像电影长片这样的长项目可能会被分成好几卷。

出处:R. Loughlin & D. Schweickart | Frame.io

编译:Charlie | 盖雅翻译小组

-300x152.x33687.jpg)